Resumo

Como a opacidade algorítmica está moldando a prática social e transformando nossa concepção sobre o trabalho? Neste artigo reflito sobre o impacto dos algoritmos de aprendizado que, ao operarem de maneira opaca, têm efeitos significativos sobre o ambiente laboral. Analiso como a falta de transparência nas decisões automatizadas pode comprometer os direitos dos trabalhadores e alterar as normas e práticas laborais. Evidencio que a opacidade dos algoritmos frequentemente resulta em decisões arbitrárias, marginalizando trabalhadores e promovendo injustiças no local de trabalho. Apresento uma perspectiva que parte da ideia que as tecnologias disruptivas e opacas modificam a rede conceitual do trabalho, gerando insegurança e desigualdade. Para concluir, afirmo que é crucial exigir maior transparência nos algoritmos e responsabilizar as empresas para evitar a erosão dos direitos trabalhistas. Enfatizo a necessidade de um engajamento crítico para garantir que a evolução tecnológica não perpetue injustiças e incertezas no ambiente laboral.

1. Introdução

A tentativa de prever o futuro da humanidade diante do avanço tecnológico é uma pretensão arriscada e, por isso, não faz parte do objetivo do presente trabalho. Em vez disso, o objetivo é propor uma análise sobre os possíveis efeitos da mediação algorítmica na prática social do trabalho. Convém mencionar que apesar de fazer uma análise sobre o uso de tecnologias nas práticas sociais, o presente trabalho evita visões alarmistas e deterministas que sugerem cenários catastróficos provocados pela inteligência artificial. Para isso, adota-se uma definição mais simples de artificialidade como algo que foi construído por um grupo de organismos com um propósito espcífico (Romero, 2024). Assim, ainda que se reconhece a não neutralidade da tecnologia, especialmente das tecnologias disruptivas que afetam o trabalho, defende-se que o modo de utilização dessa artificialidade reside nos seres humanos, que devem estar conscientes dos riscos e desafios éticos a ela relacionados (Romero, 2024).

Com a ampliação dos sistemas sociais por meio da tecnologia, surgem novas dinâmicas e interações. Os sistemas sociais, incluindo os tecnológicos, são compostos por elementos interdependentes que transformam as dinâmicas e estruturas das práticas sociais (Romero, 2024). Sob essa ótica, tecnologias como a inteligência artificial (IA) impactam o trabalho ao introduzirem novos elementos —como novas formas de opacidade— nas práticas laborais. Nesse contexto, o problema central investigado neste artigo é o impacto da opacidade algorítmica —e novas formas de segregação como consequência dessa opacidade— sobre as práticas e valores do trabalho. Quando algoritmos opacos tornam-se mediadores de decisões no ambiente laboral, observa-se uma segregação epistêmica que compromete a autonomia e a transparência dessas práticas, perpetuando desigualdades e incertezas. A questão que se coloca é se essa opacidade —ao tornar o ambiente de trabalho mais arbitrário e desigual— pode também alterar a concepção e o valor social do trabalho, deixando-o mais sucetível a práticas exploratórias e à erosão fragmentada dos direitos trabalhistas.

Uma perspectiva crítica sobre os efeitos da opacidade algorítmica no ambiente de trabalho sugere que essa característica dos algoritmos pode não apenas transformar práticas laborais, mas também modificar a noção mesma do próprio conceito de trabalho —isto é, como representamos o trabalho no mundo e como o comprendemos socialmente. A opacidade algorítmica, ao dificultar o entendimento dos processos decisórios mediados por IA, reduz a capacidade dos trabalhadores de compreender, contestar ou participar efetivamente dessas decisões. Em vez de explorar cenários especulativos de uma possível dominação da IA, o presente trabalho enfatiza que os efeitos concretos e já visíveis da inteligência artificial exigem atenção, pois, em vez de eliminar empregos de forma abrupta, a IA vem contribuindo para a centralização de poder nas empresas, intensificando desigualdades pré-existentes e limitando a autonomia dos trabalhadores (Kapoorsayash Kapoor e Narayananarvind Narayanan, 2023). Partindo da inspiração da noção de “disrupção conceitual” (Lohr, 2023), este trabalho propõe que a opacidade algorítmica desafia as normas e valores do trabalho, introduzindo nessa esfera da vida novos elementos que demandam uma reavaliação crítica e urgente dessa prática social. Para mitigar os efeitos prejudiciais da opacidade, torna-se essencial implementar regulamentações que promovam a transparência e protejam os direitos dos trabalhadores.

Para desenvolver esta análise, inicialmente será apresentada uma definição de trabalho e dos valores envolvidos nesta prática social. Essa definição ajudará a relacionar as práticas laborais normativas com os problemas gerados pela opacidade algorítmica. Em seguida, será introduzido o conceito de algoritmo e esclarecida a questão da opacidade associada a sistemas de aprendizado de máquina, que gera uma preocupação epistêmica devido à dificuldade de entender como os algoritmos chegam aos resultados classificatórios usados nos processos decisórios no ambiente de trabalho.

Na sequência, aborda-se diretamente a opacidade algorítmica na mediação do trabalho. Em primeiro lugar, discute-se o aspecto sistêmico da opacidade e o potencial desta, quando aplicada em larga escala, de gerar resultados indesejáveis no contexto laboral, interferindo na realidade sociopolítica. Em segundo lugar, será explorado como as preocupações epistêmicas abrangem também valores não epistêmicos relacionados ao impacto da opacidade, exemplificados pela segregação epistêmica que afeta trabalhadores precarizados nas plataformas digitais. O modelo de negócios dessas empresas demonstra como a tecnologia disruptiva pode gerar mal-estar laboral, corroendo os direitos e valores associados ao trabalho.

Com inspiração na perspectiva de Guido Löhr (2023), argumenta-se que as tecnologias socialmente disruptivas têm o potencial de modificar nossas concepções sobre conceitos estabelecidos. Se os processos decisórios no trabalho forem mediados por uma opacidade algorítmica sistêmica que resulta em consequências indesejáveis, como a segregação epistêmica, e se a introdução de perturbações na realidade altera o conceito representado pela prática, então a deliberação mediada pela opacidade pode contribuir para transformar tanto a prática social do trabalho quanto o conceito que ela representa.

Finalmente, este artigo argumenta que a opacidade algorítmica mediando o trabalho é capaz de alterar a rede conceitual do trabalho, uma vez que nossos conceitos estão vinculados ao acesso tecnológico ao mundo. Mudanças nas normas e práticas sociais introduzidas pelo desenvolvimento tecnológico impactam a rede conceitual, afetando o próprio conceito de trabalho. A análise demonstrará como a transformação dessa rede começa com a introdução ou eliminação de novos conceitos e novas relações inferenciais entre os conceitos existentes. E assim começamos.

2. A prática social do trabalho

Para esboçar uma definição para a noção de trabalho, recorre-se à análise de Raymond Geuss (2021) no livro A Philosopher Looks at Work. Raymond Geuss (2021) propõe três componentes centrais e comuns para designar uma atividade como trabalho: (i) exigir esforço mensurável e extenuante —dependendo de condições físicas, psicológicas e estados de treinamento; (ii) suprir uma necessidade no sentido de sobrevivência individual e coletiva e (iii) participar de uma objetividade —no sentido de que pode ser entendido como um processo separado e com possibilidade de avaliação e execução independentes daqueles que o realizam. Além desses três componentes, Geuss (2021) também identifica mais três características adicionais para definir uma atividade como trabalho: (iv) ter distinção e independência em relação a outras atividades; (v) divergir de diversão, prazer ou brincadeira; (vi) contar com remuneração.

Por objetividade, Geuss (2021) refere-se a: a) possibilidade do trabalho seguir procedimentos objetivos e manipular coisas por meio de processos mecânicos identificáveis em produção contínua; b) a possibilidade dos procedimentos realizados no trabalho poderem ser seguidos por outros em caso de substituição do trabalhador; e c) a capacidade do trabalhador agir de acordo com uma série de formas que podem ser identificadas com um resultado desejado. Para melhor compreensão, convém especificar que “objetividade” aqui se refere ao caráter sistemático e replicável das tarefas realizadas no trabalho, de maneira a permitir sua análise e avaliação independente. Sob a perspectiva de Danaher e Nyholm (2021), essa objetividade pode ser compreendida como uma estrutura de tarefas que envolve a contribuição de um grande número de pessoas (os trabalhadores). Eles definem o espaço que estrutura essas tarefas como o espaço de trabalho.

Para o propósito desta análise, serão utilizados integralmente os itens (i), (ii) e (iii) propostos por Geuss (2021). Essa escolha é basicamente pragmática, sendo os itens mencionados, segundo Geuss (2021), os mais comuns para designar uma atividade como trabalho. Considera-se que os demais seriam apenas complementos que podem variar segundo o tipo de atividade e que podem gerar desacordos. Por exemplo, certos trabalhos, por ejemplo, a função de “influencer” não é exercida com independência de outros âmbitos da vida, pelo contrário, explora-se outros âmbitos, como a intimidade, para o ganho financeiro. Parte-se também da ideia de Marx (2010) de que o trabalho emerge na sociedade a partir dos seus modos de organização, como um processo entre o homem e a natureza. Adicionalmente, se considerará a visão de Danaher e Nyholm (2021) de que, do ponto de vista econômico, o trabalho envolve o desenvolvimento de competências específicas, referidas como “skills“. Essas competências são habilidades técnicas e não técnicas adquiridas e aplicadas ao longo do tempo. Acredita-se que essas ideias podem ser combinadas para formular uma definição conceitual de “trabalho” útil para a análise proposta. Assim, propõe-se que algo é trabalho (T) se e somente se:

(i) T é um processo que nasce de uma dada organização social X.

(ii) T está envolvido em uma objetividade P.

(iii) T é uma atividade Q (que requer esforço ou gasto de energia que pode ser mensurado, depende de condições físicas, psicológicas e estados de treinamento, se diferencia do lazer e consiste no desenvolvimento de competências).

(iv) T supre uma necessidade Y (seja biológica, econômica, por exemplo, a remuneração, ou psicológica).

Em outras palavras, T é trabalho se e somente se é um processo que nasce em uma dada organização social X dentro de uma objetividade P, subdividido em um tipo de atividade Q para suprir uma necessidade Y. Essa definição permite uma visão abrangente do trabalho, integrando aspectos teóricos e práticos.

Além de definir o conceito, afirmar que uma prática social é considerada trabalho implica, segundo Horgan (2021), que essa prática segue um marco de direitos definidos politicamente. Esse marco faz do trabalho uma prática social regulamentada por um conjunto específico de leis e regulamentos que definem direitos e responsabilidades, como a Lei X e a Norma Y, que estabelecem diretrizes claras para a proteção dos trabalhadores e a responsabilização dos empregadores (Horgan, 2021, p. 1113). Isso significa que a definição de trabalho não é apenas teórica, mas também envolve a aplicação de normas e direitos específicos. Danaher e Nyholm (2021) destacam que o trabalho ocupa um espaço central na vida das pessoas.

Essas normas e direitos, reconhecidos pela Organização Internacional do Trabalho —OIT (2004), fazem do trabalho uma parte central da vida e podem ser ser sintetizados no conceito de “trabalho decente”. Segundo a Organização Internacional do Trabalho, o trabalho decente deve: (i) “dignificar”, (ii) “permitir o desenvolvimento das capacidades individuais”, (iii) “distinguir-se de outros”, (iv) “cumprir com a lei”, (v) “remunerar justamente”, (vi) “não discriminar” e (vii) “cumprir com normas de proteção social, diálogo e tripartismo”. A definição de trabalho decente inclui valores fundamentais associados ao trabalho, “incluindo dignidade, realização, autonomia, mérito, distinção, responsabilidade, justiça, igualdade e comunalidade”. Na perspectiva adotada aqui, esses valores incluem, por exemplo, dignidade, realização, autonomia, mérito, distinção, responsabilidade, justiça, igualdade e comunalidade. Antes de abordar o tema da opacidade algorítmica na mediação do trabalho, será realizada uma breve análise isolada do problema da opacidade, examinando as suas causas e problemas.

3.O problema epistêmico da opacidade

Esta seção começa com a introdução da noção de algoritmo. Para isso, adota-se a definição de Hill citada por Tsamados et al. (2021) em The Ethics of Algorithms: Key Problems and Solutions. Segundo essa definição, um algoritmo é uma construção matemática composta por uma estrutura de controle finita, abstrata, efetiva e imperativamente definida, que cumpre um propósito específico sob certas condições (Tsamados et al., 2021, p. 3). Para alcançar esse propósito, o algoritmo deve estar integrado em um sistema, que, por sua vez, é implementado em programas e aplicações (Mittelstadt et al., 2016, p. 2). Dentro de um sistema, o algoritmo — projetado pelo raciocínio humano — segue uma racionalidade que determina sua função de analisar um conjunto de dados de um domínio específico e, a partir disso, incorpora uma estrutura matemática abstrata por meio de processos operacionais (Mittelstadt et al., 2016, p. 2). No entanto, é importante observar que a complexidade e a opacidade dos algoritmos podem variar amplamente, o que nem sempre é refletido nas definições mais gerais. Justin Joque (2022) explica que Donald Knuth, cientista da computação, define “a arte da programação de computadores” como um sistema baseado em cinco requisitos: (i) a finitude, pois um algoritmo tem um tempo limitado para ser executado e concluído; (ii) a definição, pois cada passo do algoritmo é definido “rigorosamente e sem ambiguidade”; (iii) uma entrada, que constitui um processo de entrada que resulta em (iv) uma saída; e (v) “a efetividade do processo, marcada pela simplicidade de cada passo para uma compreensão fácil e possível execução” (Joque, 2022, p. 67).

Os algoritmos podem ser de diferentes tipos, mas compartilham um ponto em comum, que é o “intento de trazer algo ao mundo material”, seja esse algo uma ideia, um cálculo ou uma experiência anterior (Toscano, 2022, p. 50). Apesar da definição clara de algoritmos, a implementação e a complexidade dos sistemas de aprendizado de máquina (ML) podem levar a diferentes níveis de opacidade. O foco, neste caso, está nos sistemas que utilizam algoritmos de aprendizado de máquina (ML — machine learning). Esses sistemas, segundo Loi et al., “passam por um processo de treinamento baseado em dados digitais” (Loi et al., 2021, p. 13). Nos sistemas de ML, os algoritmos recebem dados de entrada (inputs) e, a partir deles, criam uma cadeia de dados que são avaliados como saídas (outputs) (Joque, 2022, p. 45). A opacidade desses sistemas pode variar de acordo com o tipo de modelo de ML e a complexidade do treinamento. É relevante notar que esses algoritmos são utilizados em programas e aplicações que automatizam processos deliberativos, como sistemas de classificação de crédito, uso clínico e análise de reincidência em sistemas de justiça e policiais (Loi et al., 2021, p. 13; Mittelstadt et al., 2016, p. 3). Neste trabalho, consideramos um processo deliberativo como qualquer processo que envolve tomada de decisão, como decidir sobre ações em relação a situações específicas, por exemplo, a demissão de um funcionário. Quando algoritmos são usados em processos deliberativos, a dificuldade em entender como produzem suas decisões pode comprometer a transparência e a justiça.

A função classificatória dos sistemas de ML suscita algumas preocupações. Segundo Tsamados et al. (2021), essas preocupações se dividem em duas categorias: (i) epistêmicas e (ii) normativas. As preocupações epistêmicas referem-se à evidência inconclusiva, inescrutável e incorreta. Por outro lado, as preocupações normativas estão relacionadas a resultados injustos e impactos transformadores. Além disso, Tsamados et al.(2021) também discutem a questão da rastreabilidade, que pode ser tanto epistêmica quanto normativa. No presente trabalho, o foco está na evidência inescrutável, associada à opacidade e à falta de transparência nos processos algorítmicos.

A evidência inescrutável, uma das preocupações éticas levantadas pela tecnologia algorítmica nos sistemas de aprendizado de máquina, resulta em opacidade. A opacidade ocorre porque os algoritmos de ML operam de maneira que o processo interno de tomada de decisão não é plenamente compreendido nem explicado. Para compreender melhor a opacidade, é necessário retornar ao tema dos algoritmos de aprendizado. Nos sistemas de aprendizado, os algoritmos passam por um processo de capacitação e treinamento que pode ser descrito técnicamente como o desafio de “melhorar alguma medida de desempenho P ao executar uma tarefa T, por meio de algum tipo de experiência de treinamento E” (Loi et al., 2021, p. 254). No entanto, a capacidade de aprimorar o desempenho pode ser limitada pela dificuldade em interpretar os processos internos do algoritmo. Na prática, isso ocorre porque o processo de programação algorítmica envolve etapas como a entrada e a saída de dados. Durante o treinamento, os dados são inseridos (entrada) e, posteriormente, integrados em uma infraestrutura que gera novas previsões (saída), automatizando decisões (Loi et al., 2021, p. 255). Assim, o sistema opera como um “motor cognitivo” (Loi et al., 2021, p. 255) que processam os dados de entrada e classificando-os para a tomada de decisão (Burrell, 2016, p. 1). Esse funcionamento confere aos sistemas um certo grau de autonomia (Mittelstadt et al., 2016, p. 3). No entanto, esse grau de autonomia aliado à dificuldade de interpretação pode resultar em decisões que não são totalmente compreendidas, gerando um nível de opacidade preocupante.

Loi et al (2021) afirmam que os processos deliberativos em algoritmos de aprendizado operam dentro de um limite epistêmico que impede a compreensão completa de seus processos internos, tornando-os inescrutáveis. De acordo com Loi et al. (2021, p. 256), “uma explicação sobre X é eficaz quando o que é explicado sobre X é claro e acessível para as pessoas que desejam entender X“. Porém, a inescrutabilidade dos sistemas de ML pode comprometer essa clareza e, consequentemente, a eficácia comunicativa. Esse fator deve-se principalmente à falta de transparência no “comportamento do sistema algorítmico” (Loi et al., 2021, p. 256). Esse problema não seria crítico caso as decisões baseadas em ML não impactassem direta ou indiretamente a vida das pessoas. Contudo, elas têm um impacto significativo.

O conceito de transparência algorítmica é definido pela sua eficácia comunicativa. Se a comunicação fornece as “informações essenciais necessárias” para explicar o design do sistema de forma satisfatória, então ela é transparente (Loi et al., 2021, p. 257). Isso é crucial para determinar se as decisões algorítmicas são “moralmente arbitrárias” (Loi et al., 2021, p. 260). Para entender o que constitui uma decisão moralmente arbitrária, é importante compreender o conceito de moral. Segundo González e Teixidó (2023) em “Derechos, deberes, justicia y simetría moral desde una filosofía científica”, a moral pode ser vista como um conjunto de normas sociais, construídas individual ou coletivamente, com o propósito de motivar ações ou inibições em situações envolvendo valores humanos em conflito. Nesse contexto, a moral orienta o comportamento humano quando diferentes valores estão em jogo. Os algoritmos, ao reproduzirem sistemas de regras que orientam decisões, podem incorporar elementos de teor moral. A arbitrariedade dessas decisões, portanto, pode surgir (i) da reprodução de sistemas morais desiguais e (ii) da falta de transparência sobre as regras seguidas pelos algoritmos. González e Teixidó (2023) argumentam que a equidade moral busca o equilíbrio simétrico entre normas estabelecidas socialmente. Assim, se aplicamos essa ideia para nosso tema, podemos afirmar que a arbitrariedade algorítmica viola princípios morais ao gerar ou perpetuar desequilíbrios já existentes. Os algoritmos de machine learning aprendem com os dados que lhes são fornecidos durante o treinamento. Se esses dados refletirem preconceitos e desigualdades da sociedade, as decisões algorítmicas tenderão a replicar essas distorções. Por exemplo, um algoritmo treinado com dados históricos de contratações pode associar cargos de liderança predominantemente ao gênero masculino, discriminando candidatas mulheres.

A transparência é, portanto, fundamental para permitir que as partes interessadas compreendam e avaliem as decisões algorítmicas de forma adequada. Se a comunicação falha em fornecer as informações necessárias, a transparência não é alcançada, resultando em opacidade. A opacidade dos sistemas algorítmicos é uma preocupação epistêmica central, pois a dificuldade em entender como os algoritmos chegam a determinadas conclusões pode levar a decisões moralmente arbitrárias (Burrell, 2016, p. 1).

Alguns autores, como Ferreira (2021), argumentam que a opacidade não é um problema sério, pois a natureza inescrutável dos sistemas algorítmicos não representa maior risco de arbitrariedade do que as decisões humanas. Ferreira defende que, apesar dos desafios epistêmicos, os sistemas de ML podem ser justos e eficazes em processos deliberativos. Contudo, mesmo reconhecendo que os algoritmos podem produzir resultados justos em certos casos, a opacidade continua sendo uma preocupação ética relevante. A falta de compreensão dos processos internos pode gerar sérias implicações éticas, especialmente em contextos que exigem justiça e responsabilidade. Portanto, é crucial abordar a opacidade de forma crítica e abrangente, assegurando que os sistemas de aprendizado de máquina sejam empregados de maneira ética e responsável, particularmente em ambientes onde as decisões afetam diretamente a vida das pessoas.

4. A prática social do trabalho mediada pela tecnologia algorítmica

Até aqui, as noções de trabalho e opacidade foram discutidas separadamente. Agora, é necessário integrá-las para avançar em direção à proposta do presente trabalho. Como mencionado, algo pode ser considerado trabalho se e somente se é um processo que surge em uma organização social X e se envolve em uma objetividade P, dividida em um tipo de atividade Q para suprir uma necessidade Y. Discutir a mediação algorítmica no trabalho é examinar como os sistemas algorítmicos estão presentes na objetividade do ambiente laboral, influenciando as regras e protocolos que determinam a atividade em questão.

Se um sistema de aprendizado algorítmico classifica dados em um domínio específico, os processos deliberativos relacionados a esse domínio são impactados pela natureza dessa classificação. No contexto do trabalho, quando os processos inferidos por sistemas classificatórios são opacos, isso afeta diretamente o domínio laboral, potencialmente gerando arbitrariedade, uma vez que as decisões seguem uma lógica não transparente. Decisões arbitrárias podem levar a consequências indesejáveis, como a segregação epistêmica, que, neste estudo, é entendida como a divisão de indivíduos em grupos com acesso desigual a informações e conhecimentos. A segregação epistêmica representa um desafio para a democracia ao limitar a diversidade de perspectivas, dificultar a construção de conhecimento compartilhado e comprometer a qualidade do debate público e da tomada de decisões coletivas. Antes de explorar a segregação epistêmica em mais profundidade, é importante esclarecer os tipos de trabalho mediado por sistemas algorítmicos.

A segregação epistêmica representa um desafio para a democracia ao limitar a diversidade de perspectivas, dificultar a construção de conhecimento compartilhado e comprometer a qualidade do debate público e da tomada de decisões coletivas. Antes de explorar a segregação epistêmica em mais profundidade, é importante esclarecer os tipos de trabalho mediado por sistemas algorítmicos. Exemplos de funções laborais mediadas por algoritmos incluem processos de seleção de trabalhadores (Páez e Ramírez-Bustamante, 2022), avaliações de desempenho e produtividade em plataformas de entrega de alimentos como Glovo, Deliveroo e UberEats, e até sistemas para aplicação de medidas disciplinares e demissões (Asquerino Lamparero, 2022). Essas classificações têm impactos concretos: influenciam a contratação, a remuneração e a desativação de trabalhadores (Suarez, 2023).

Retornando à questão da segregação, entendemos que ela é uma consequência da opacidade algorítmica. Portanto, antes de abordá-la diretamente, é preciso esclarecer o conceito de opacidade algorítmica no contexto sistêmico.

4.1.A opacidade algorítmica sistêmica

Ferreira (2021) argumenta que a opacidade faz parte da natureza dos algoritmos e, por si só, não é problemática. Burrell (2016), por sua vez, identifica três formas de opacidade: (i) opacidade por direito de propriedade, associada à proteção corporativa e ocultamento institucional (Burrell, 2016, p. 3); (ii) opacidade por “analfabetismo técnico”, que exige conhecimento especializado para decodificar algoritmos; e (iii) opacidade resultante do desajuste entre o aprendizado de máquina e a interpretação humana (Burrell, 2016, p. 2). Essas formas ajudam a compreender por que Ferreira defende que sempre haverá algum grau de opacidade. Contudo, essa perspectiva não é suficiente.

Creel e Hellman (2022) argumentam que o problema da opacidade é sistêmico, não isolado. Quando a opacidade se torna sistemática em grande escala, ocorre uma aplicação uniforme de classificações que pode resultar em segregação social e econômica, o que as autoras chamam de opacidade epistêmica sistêmica. Esse problema começa com o monopólio de fornecedores privados que projetam a maioria dos sistemas algorítmicos, padronizando preconceitos e critérios de design (Creel e Hellman, 2022, p. 1).

A análise de Creel e Hellman (2022) permite avaliar a dimensão do uso desses sistemas no contexto do trabalho. Por exemplo, a concentração de controle e a falta de transparência nos sistemas algorítmicos utilizados por plataformas digitais de entrega de alimentos ilustram como a opacidade pode levar ao que Stuart et al. (2023) chamam de um “mal-estar laboral” (p. 3). Com poucas grandes empresas dominando o setor, a falta de transparência nos critérios de avaliação pode resultar em práticas uniformemente prejudiciais. Segundo o documento “Infografía—Panorámica de las plataformas digitales en la UE” (2023), havia 28,3 milhões de trabalhadores de plataformas digitais na União Europeia em 2022, e a expectativa é que esse número atinja 43 milhões até 2025. Se nenhuma mudança for implementada, mais pessoas estarão sujeitas a ambientes digitais marcados pela opacidade e segregação.

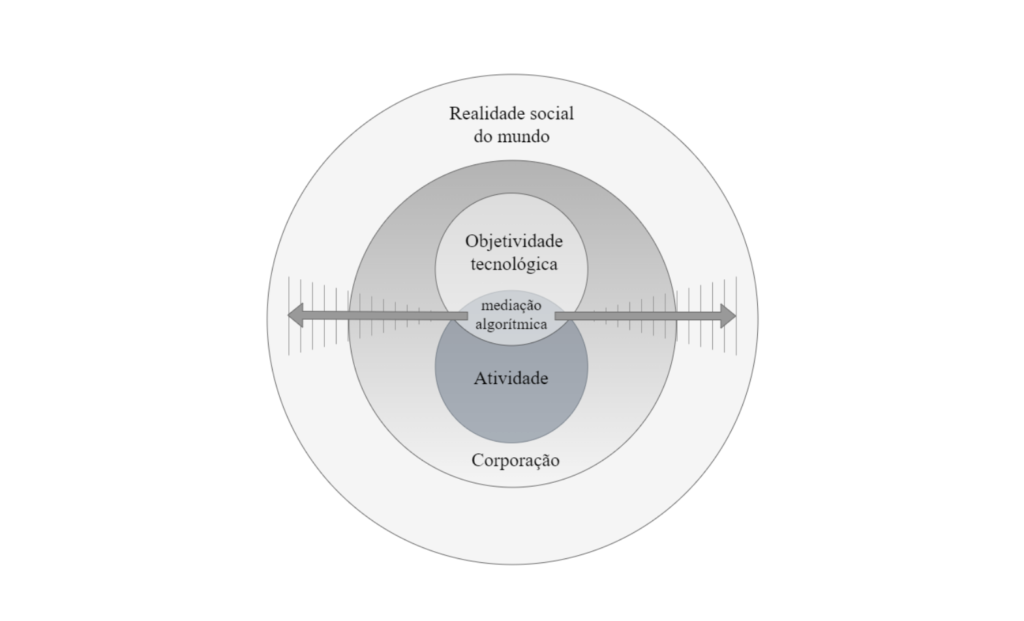

Portanto, a perspectiva de Creel e Hellman (2022) sugere que, quando aplicada uniformemente em larga escala, a opacidade sistêmica afeta não apenas o ambiente de trabalho, mas toda a realidade sociopolítica. Esse impacto se dá de dentro — da objetividade tecnológica das empresas — para fora, afetando o mundo sociopolítico, como ilustrado na imagem abaixo:

Voltando a definição de trabalho apresentada no apartado 1 do presente trabalho, o que se pode mencionar é que ao tornar-se parte integrante das estruturas de trabalho, os algoritmos se inserem no processo social em que o trabalho é produzido, transformando a organização do próprio ambiente laboral (condição (i) do conceito). A interferência dessa tecnologia gera um novo tipo de objetividade (ii), centrada nas decisões automatizadas que escapam à compreensão direta dos trabalhadores e, com isso, introduzem arbitrariedades e segregações epistêmicas que prejudicam a transparência. Além disso, o esforço e o gasto de energia dos trabalhadores (iii) são medidos e monitorados por sistemas algorítmicos que determinam as métricas de produtividade e desempenho sem transparência, limitando a autonomia dos trabalhadores para ajustar suas competências em função dos critérios objetivos. Por fim, a opacidade dos algoritmos pode também impactar a satisfação das necessidades dos trabalhadores (iv) ao enfraquecer as normas que tradicionalmente garantem remuneração justa e segurança no trabalho. Dessa forma, o conceito de trabalho é alterado, pois o caráter opaco dessas tecnologias redefine as expectativas sobre o que constitui um “trabalho decente” e digno de reconhecimento social, comprometendo valores centrais como autonomia, justiça e igualdade.

Em resumo, a prática social do trabalho mediada por tecnologia algorítmica é impactada por processos deliberativos caracterizados pela opacidade, levando à arbitrariedade e à segregação epistêmica. Como discutido, essa segregação é evidente em processos de seleção e avaliação, muitas vezes projetados por poucos fornecedores que seguem padrões que exacerbam injustiças e limitam a compreensão dos trabalhadores sobre as decisões que os afetam. A opacidade favorece as empresas, prejudica os trabalhadores e limita a capacidade de contestação.

4.2.Opacidade epistêmica e segregação epistêmica

De acordo com Sullivan (2022), as preocupações epistêmicas relacionadas à opacidade também envolvem valores não epistêmicos, como a preocupação por justiça, responsabilidade e equidade. A complexidade dos modelos algorítmicos de aprendizado automático dificulta a explicação de como chegam às suas conclusões. Isso é particularmente relevante em contextos em que esses modelos influenciam decisões significativas, como as que afetam trabalhadores em processos de seleção e gestão de pessoal. Considerando as preocupações epistêmicas como a dificuldade de entender os processos de classificação dos sistemas, a falta de explicações claras compromete a transparência das informações que afetam a vida das pessoas (Sullivan, 2022, p. 6). Essa ausência de clareza afeta a capacidade de explicação, prejudicando sistematicamente os interesses dos trabalhadores.

Para ilustrar casos concretos, considere as plataformas digitais. Uma carta do sindicato dos trabalhadores dessas plataformas na França revela que a opacidade impede a compreensão de como as tarifas horárias são definidas, dificultando a avaliação e reivindicação de valores justos (Suarez, 2023). Além disso, a falta de clareza nos critérios de desativação repentina das plataformas impede os trabalhadores de questionar tais decisões. O relatório Algorithmic Management: Opportunities for Collective Action (UNI Global Union, 2023) aponta que os sistemas algorítmicos monitoram rigorosamente o desempenho, impondo metas frequentemente irreais e afetando a saúde física e mental dos trabalhadores. Dubal (2023) observa que, na plataforma Uber, a opacidade nos cálculos de pagamento promove discriminação salarial, resultando em desigualdades injustificadas. Essa falta de transparência intensifica a segregação epistêmica, prejudicando a capacidade dos trabalhadores de compreenderem as causas das diferenças salariais. Portanto, a opacidade sistêmica afeta negativamente a dimensão laboral, refletindo-se em vários países e contextos. Esse problema não se restringe a casos específicos, mas é um fenômeno global com amplas implicações.

Além disso, Páez e Ramírez-Bustamante (2022) destacam que a opacidade algorítmica afeta processos de contratação e avaliação de desempenho. Algoritmos de seleção podem perpetuar preconceitos ao basear-se em dados que refletem desigualdades sociais. Consequentemente, certos grupos são excluídos de oportunidades de emprego, enquanto outros são favorecidos por critérios opacos e injustos. Avaliações de desempenho também sofrem com a falta de transparência, dificultando a contestação de decisões e o entendimento de como melhorar dentro dos parâmetros das plataformas. Essa opacidade contribui para a segregação epistêmica, privando os trabalhadores das informações necessárias para compreender seus direitos e desempenho.

A combinação dessas formas de opacidade — que vai desde a propriedade e o analfabetismo técnico até o desajuste epistêmico sistêmico — revela um quadro complexo onde a transparência e a equidade no ambiente de trabalho são comprometidas. Portanto, abordar criticamente esse fenômeno e implementar soluções que promovam a transparência são medidas essenciais. Tais soluções podem incluir regulamentações mais rigorosas sobre algoritmos em processos laborais e práticas que assegurem decisões mais justas e compreensíveis.

Em resumo, a análise da opacidade algorítmica e seus impactos sistêmicos revela a necessidade urgente de ações para garantir que as tecnologias utilizadas no trabalho sejam projetadas e aplicadas de maneira transparente e equitativa. Somente assim é possível mitigar os efeitos prejudiciais da segregação epistêmica e assegurar que o trabalho mediado por algoritmos respeite os direitos e a dignidade dos trabalhadores, promovendo um ambiente de trabalho mais justo e inclusivo.

4.3.Alterações no conceito de trabalho

Antes de discutir os impactos da opacidade algorítmica nas práticas laborais, é importante reconhecer, como argumenta Stephanie Hare (2022, p. 16), a tecnologia não é neutra. Hare entende a tecnologia como parte do que nos torna humanos e destaca que ela media a relação entre cidadãos e governos, consumidores e empresas, entre outros. Além disso, Hare (2022, p. 42 e 43) argumenta que a tecnologia não é apenas uma ferramenta, mas um sistema complexo que envolve aspectos como racionalidade, poder, controle, linguagem e conhecimento. Nesse sentido, Hare considera que o termo “caixa preta”, usado para descrever a falta de transparência dos sistemas algorítmicos também pode ser apropriado para representar o desconhecimento sobre o funcionamento do sistema, o que dificulta não só a compreensão de seus processos internos, mas também a previsão de como o uso contínuo do sistema pode afetar a realidade ao longo do tempo (Hare, 2022, p. 59).

Embora seja fascinante refletir sobre as possíveis mudanças que a tecnologia pode provocar na realidade, o objetivo aqui é analisar especificamente a opacidade algorítmica na mediação do trabalho. Em vez de explorar as múltiplas implicações dessa mediação, a análise se concentrará em refletir em como os mecanismos de representação podem ser afetados. Interessa pensar como as pequenas mudanças na normativadade das práticas laborais podem influenciar em como representamos a prática que conhecemos como trabalho. Considerando que a linguagem se organiza em um sistema de representações, o objetivo não é apenas discutir o trabalho como prática social, mas também como um conceito que envolve interações objetivas e estruturadas, passíveis de análise.

Inspirada na perspectiva de Guido Löhr (2023) sobre como as tecnologias socialmente disruptivas podem mudar nossas concepções de determinados conceitos, argumenta-se que, se os processos deliberativos no trabalho são mediados por uma opacidade algorítmica que gera efeitos indesejáveis, como a segregação epistêmica sistêmica, e se a introdução de perturbações na realidade pode mudar o conceito que essa prática representa, então a deliberação mediada por opacidade pode contribuir para transformar tanto a prática social do trabalho quanto o conceito associado a ela. Em outras palavras, quando produz segregação epistêmica, a opacidade sistêmica pode transformar não apenas a prática social conhecida como trabalho, mas também a nossa concepção do trabalho e dos valores que ele representa. De maneira semelhante, Horgan (2021) propõe que o deslocamento do conceito de trabalho em múltiplas direções — como trabalho emocional, trabalho autônomo, etc. — adiciona novos elementos (ou novos conceitos) ao conceito principal, alterando assim como o assimilamos e representamos.

Hare (2022) afirma que a tecnologia faz parte do que nos torna humanos, e Löhr (2023) destaca que, de acordo com os filósofos da tecnologia, nosso acesso ao mundo ocorre necessariamente através da mediação tecnológica. Löhr sugere que nossos conceitos estão envolvidos nesse acesso, implicando que discutir o desenvolvimento tecnológico é também discutir nosso aparato conceitual. A tecnologia socialmente disruptiva (TSD) é definida como aquela que provoca modificações significativas em práticas sociais, gerando grandes transformações (Rueda, 2021, p. 6). Por essa definição, as plataformas digitais podem ser consideradas tecnologias socialmente disruptivas. Quando aplicadas ao trabalho, essas tecnologias causam mudanças e perturbações na percepção sociopolítica que o trabalho representa. O exemplo das plataformas ilustra como casos específicos de opacidade podem resultar em segregação epistêmica que afeta uma classe social específica, criando perturbações no ambiente laboral.

Löhr (2023) destaca que qualquer alteração em nossas percepções sobre um conceito provoca mudanças na forma como pensamos sobre ele. Partindo dessa ideia, argumenta-se que a opacidade dos sistemas algorítmicos pode transformar nossa percepção sobre o trabalho, conduzindo a alterações futuras em nosso entendimento do conceito. Uma perturbação pode ser definida como qualquer alteração no estado atual. Em outras palavras, rupturas gradativas na prática social do trabalho têm potencial para modificar nossa percepção dessa dimensão social, resultando em mudanças conceituais. Não se pode afirmar se essas mudanças serão positivas ou negativas. Löhr (2023) usa o exemplo do ventilador mecânico para ilustrar como a tecnologia pode alterar nossa compreensão sobre a morte — antes definida por critérios cardiopulmonares, agora por parâmetros neurológicos. as transformações nas condições objetivas do trabalho, como as mudanças tecnológicas e sociais, influenciam diretamente a estrutura e as práticas que o definem. Dessa forma, a percepção alterada do trabalho, resultante da interferência de tecnologias complexas e opacas, pode conduzir a modificações gradativas em sua conceituação, assim como a introdução de novos critérios de avaliação.

Löhr (2023, p. 1) explica que o desenvolvimento tecnológico pode alterar a compreensão dos propósitos e normas de um conceito, gerando mudanças sociais e morais significativas. Quando ocorre uma mudança em torno de um conceito, há uma ruptura que afeta nosso entendimento sobre ele, levando à “incerteza classificatória” (Löhr, 2023, p. 1). Isso implica uma incerteza nas condições usadas para classificar o conceito. Por exemplo, a discriminação salarial enfrentada por trabalhadores de plataformas ilustra como práticas discriminatórias podem violar normas de não discriminação e segurança no trabalho, introduzindo novos elementos como instabilidade e desigualdade. Essas mudanças podem, gradualmente, minar os direitos trabalhistas e alterar a definição do trabalho. A luz dessas considerações, podemos afirmar que as perturbações na realidade laboral, tais como mudanças tecnológicas, sociais ou políticas, podem alterar o conceito de trabalho ao modificar as condições objetivas em que ele ocorre, afetando a estrutura de suas práticas, as relações entre trabalhadores e empregadores, e as formas de organização e distribuição das tarefas.

Nesse ponto do presente trabalho, é pertinente apresentar um exemplo mais empírico de como ocorre uma mudança no próprio conceito de trabalho1. No capítulo intitulado “Why and How Precarious Workers Support Neo-illiberalism” do livro “Beyond Neoliberalism and Neo-illiberalism”, Rosana Pinheiro-Machado (2024) afirma que trabalhadores de plataforma de baixa renda no Brasil, apesar da situação de precariedade, identificam-se com o discurso de empreendedorismo promovido pelas plataformas digitais. De acordo com os estudos de Pinheiro-Machado (2024), realizados ao longo de 23 anos, há uma incorporação dos valores relacionados às práticas empreendedoras entre esses trabalhadores. Entre esses valores, podemos mencionar a valorização da autonomia e da responsabilidade individual na busca pela prosperidade. Segundo a autora, essa alteração na perspectiva faz com que a responsabilidade pela desigualdade não recaia sobre o Estado, mas sim sobre o esforço do indivíduo. Nesse sentido, há uma transferência de responsabilidade na percepção do conceito de trabalho. Pinheiro-Machado (2024) explica que, de acordo com seus estudos, a maioria desses trabalhadores considera que um trabalho convencional, ou seja, aquele em que se trabalha para outra pessoa, é visto como sinônimo de acomodação na vida. Em outras palavras, o trabalho convencional não é mais valorizado e foi substituído pela valorização do empreendedorismo. Segundo Pinheiro-Machado (2024), houve uma transformação na percepção da ascensão social via trabalho, onde, se antes se valorizava a estabilidade e segurança de um emprego, hoje valoriza-se a promessa de sucesso por meio do trabalho duro (entendido como a normalização da precariedade) e da prática do empreendedorismo. A autora conclui que a precariedade econômica favorece a adesão dos trabalhadores aos tipos de trabalho fomentados pelas plataformas. Podemos afirmar que esse exemplo ilustra bem a ideia de mudança conceitual.

Nesse contexto, podemos observar que a introdução de novos valores nas normas da prática laboral, como a autonomia e a responsabilidade pessoal sobre a desigualdade, contribui para a erosão dos valores anteriores. Isso pode ser facilmente relacionado às perspectivas de segregação e opacidade mencionadas anteriormente. Nesse caso, a opacidade contribui para criar um ambiente de trabalho em que os processos decisórios são vistos como arbitrários, o que leva à desconfiança e ao enfraquecimento das normas laborais convencionais. Por sua vez, o enfraquecimento das normas laborais convencionais afeta a forma como o trabalho é representado e compreendido socialmente, enfatizando a individualidade e o empreendedorismo em detrimento de valores como segurança e transparência. Vale também mencionar que, no que diz respeito à opacidade, o limite ao acesso dos trabalhadores às informações sobre os critérios e métodos usados para decisões que afetam suas vidas reforça a desigualdade e tende a fomentar um ambiente de desigualdade, transferindo a responsabilidade para o indivíduo em vez do sistema e dos mediadores. Isso pode contribuir para a percepção equivocada de que a condição de precariedade é uma falha pessoal, e não uma alteração nas normas sociais. Por fim, o que podemos observar é que segregação e opacidade contribuem para a normalização de práticas precárias e desiguais, influenciando a forma como o trabalho é entendido. A introdução de novos elementos, como a autonomia e a responsabilidade individual pelo próprio sucesso financeiro, tal como impulsionada pelas plataformas digitais na prática social do trabalho, conforme destacada por Pinheiro-Machado (2024), é um exemplo de como a opacidade e a segregação contribuem para transformar a percepção coletiva do trabalho, fazendo com que elementos como estabilidade e proteção sejam substituídos por flexibilidade e autossuficiência.

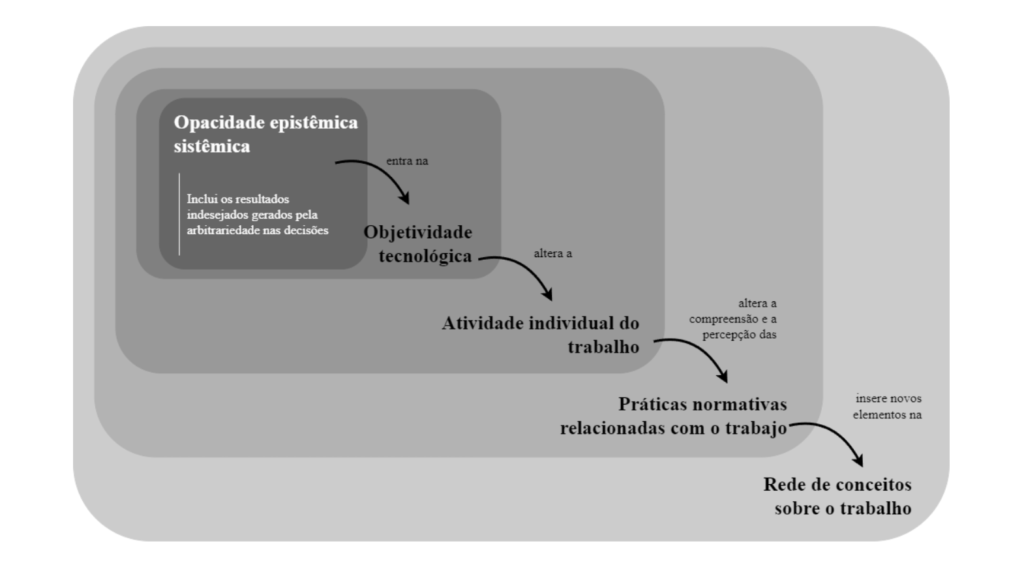

Segundo Löhr (2023, p. 2), a perspectiva de mudança num conceito X qualquer surge a partir da introdução de novos elementos na rede de conceitos relacionada a X. A mudança em uma rede conceitual começa com a introdução ou eliminação de conceitos nela ou por causa de novas relações inferenciais entre conceitos já existentes. Löhr observa que a mudança pode ocorrer mesmo quando alguns “conceitos individuais” da rede permanecem estáveis. Conforme o argumento de Löhr, pequenas mudanças na rede conceitual gradualmente causam perturbações na percepção da normatividade, resultando em uma erosão sistêmica e gradual. Segundo Löhr, nossas concepções e formas de aplicar um conceito variam entre pessoas e refletem muitas das nossas crenças, mudando conforme aprendemos, vivenciamos e conhecemos o mundo (Löhr, 2023, p. 2). Portanto, mudanças nas normas e práticas sociais alteram o conteúdo da rede conceitual, alterando assim o conceito mesmo (Löhr, 2023, p. 3). É possível ilustrar esse processo da seguinte maneira:

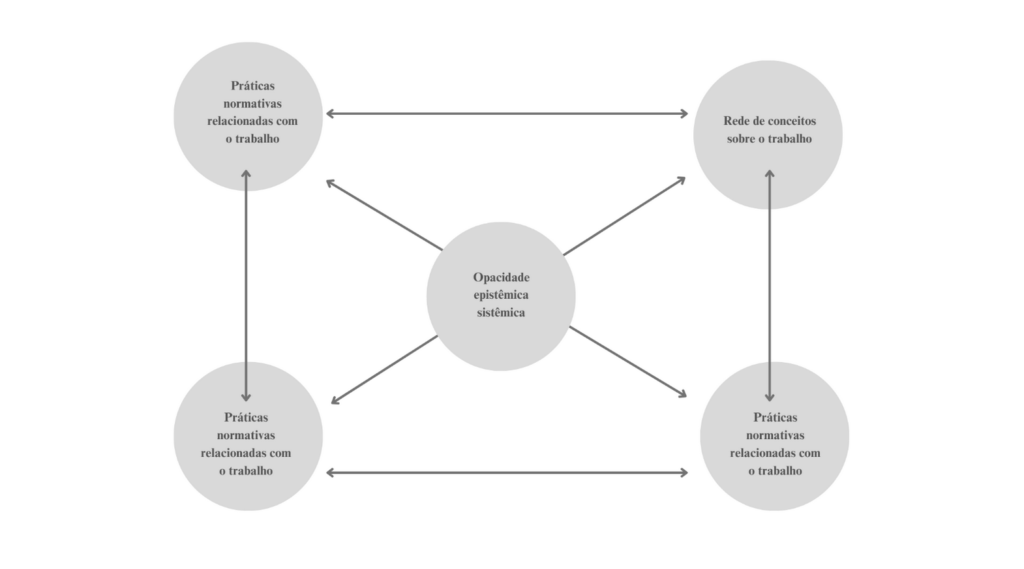

No entanto, se pensamos no contexto de não-neutralidade tecnológica, é razoável afirmar que esse processo pode, de fato, ser retroalimentado2. Pensar desde uma perspectiva de retroalimentação sugere que uma vez alterada, a rede de conceitos sobre o trabalho pode influenciar a forma como novos algoritmos são desenvolvidos e implementados. Essa perspectiva de continuidade permite repensar o processo descrito na figura 3 de uma maneira que permite contemplar também a visão de um sistema interconectado e não só uma sequência linear. Essa perspectiva encontra-se ilustrada na figura 4 a continuação. É importante ressaltar que se pensada desde uma perspectiva de interconectividade, a relação entre a rede conceitual sobre o trabalho, as práticas normativas, a prática individual, a opacidade tecnológica relacionada com o trabalho e a opacidade algorítimica ressaltaria que, assim como os algoritmos influenciam as normas e percepções sobre o trabalho, as mudanças nessas normas e conceitos também podem redefinir a forma como os algoritmos são projetados e utilizados.

Nas duas perspectivas (linear ou de interconectividade), essa maneira de considerar como um desenvolvimento tecnológico pode alterar nossa concepção coletiva sobre um determinado conceito é interessante. No entanto, na filosofia da linguagem, não há consenso sobre como possuímos conceitos, especialmente os mais abstratos, como liberdade, justiça, poder, trabalho, etc. Autores como Cappelen (2016), Soysal (2020) e Löhr (2019) sugerem que a posse de um conceito está conectada ao ambiente social. Se isso for verdade, então deve haver um grau de disposição para ajustar crenças em conformidade com mudanças no contexto do ambiente (Soysal, 2020, p. 7).

É interessante a ideia de que Löhr defende a relação entre mudanças tecnológicas socialmente significativas e a mudança na rede conceitual (Löhr, 2023, p. 4), convidando-nos a pensar que os conceitos não possuem apenas uma condição de aplicação, mas também podem ter consequências de sua aplicação. Portanto, se aceitarmos que a tecnologia não é neutra, devemos estar atentos às consequências sociais e às mudanças nas consequências da aplicação, ou seja, à relação inferencial entre os conceitos (Löhr, 2023, p. 4) relacionados ao trabalho.

Considere o caso das plataformas digitais e a segregação imposta à classe social dos trabalhadores que sofrem as consequências de práticas de precarização laboral. O fato de que um grupo de pessoas precisa se submeter ao modelo de negócios imposto por essas empresas cria um dilema moral para a sociedade: permitiremos que algumas pessoas trabalhem à margem da justiça trabalhista, sem seus direitos laborais garantidos? Segundo Danaher e Saetra (a publicar), um dos efeitos negativos da tecnologia é a imposição de uma pressão sobre as decisões, limitando-as. No caso concreto mencionado, essa flexibilização dos direitos representa uma mudança em nossos valores que gera novas permissões.

Nesse sentido, é possível questionar: O que acontecerá se interrompemos nossas práticas e normas sociais que garantem direitos no trabalho, como o direito à não discriminação ou à segurança? O que acontecerá se adicionarmos um novo contexto tecnológico à realidade sociopolítica que possibilita aceitar o não cumprimento dos direitos no marco legal do trabalho? E será que isso já não está ocorrendo de forma sistêmica na dinâmica de trabalho promovida, por exemplo, pelo modelo de negócios utilizado pelas plataformas digitais? Essas questões não são fáceis de responder. Para complementar, não se pode deixar de comentar que Cristina Bicchieri (2005) faz uma consideração muito relevante sobre mudanças normativas. Ela supõe que mudanças normativas ocorrem não apenas por alteração das regras, mas também através da adaptação dos comportamentos às novas normas e às expectativas sociais em torno delas. Assim, a dinâmica de trabalho mediada por algoritmos pode não apenas transformar práticas, mas também redefinir nossas expectativas e normas sociais relacionadas ao trabalho.

Considerações finais

A modo de conclusão, vale a pena reforçar que este trabalho tentou analisar como a opacidade algorítmica —ao distanciar trabalhadores dos processos decisórios e obscurecer as bases de decisões automatizadas— pode contribuir para transformar a própria noção de trabalho. A opacidade erige uma barreira entre trabalhadores e empresas e com isso, promove uma segregação epistêmica que ameaça a democracia no ambiente laboral ao promover injustiças. Como examinado ao longo do texto, o problema não é meramente técnico, mas estrutural, uma vez que a opacidade algorítmica altera as normas de trabalho e a forma como os trabalhadores exercem sua autonomia e entendem o papel do trabalho na esfera social.

Segundo a forma como este problema foi exposto aqui, entende-se que o enfrentamento desses desafios passa pela implementação de regulamentações de transparência algorítmica. Essa implementação pode espelhar-se em exemplos práticos das políticas. Nos Estados Unidos, a New York City Local Law 144 (DCWP, s.d.) da cidade de Nova Iorque tem o objetivo de combater a discriminação no emprego através da proibição do uso de ferramentas automatizadas de decisão de emprego (Automated Employment Decision Tools —AEDTs) a menos que a ferramenta tenha sido submetida a uma auditoria de viés, que deve ser tornada pública, e que certos avisos sejam fornecidos aos candidatos ou funcionários. O objetivo dessa lei busca garantir que as ferramentas automatizadas usadas em processos de recrutamento não perpetuem ou ampliem vieses existentes e, portanto, exigem transparência por parte das empresas, permitindo que candidatos e funcionários avaliem a justiça da ferramenta. Na União Europeia, o General Data Protection Regulation (GDPR), especialmente em seu Artigo 22 (s.d.), já assegura o direito à explicação de decisões automatizadas. Este artigo visa proteger os indivíduos de decisões automatizadas discriminatórias. As auditorias podem ajudar a identificar e mitigar o viés nos algoritmos, garantindo que as decisões de contratação sejam justas e equitativas. Outro exemplo que podemos citar é o novo AI Act da União Europeia. No site “EU AI Act: first regulation on artificial intelligence | Topics | European Parliament” (EU AI Act, 2023) é possível encontrar a descrição da Lei de IA da União Europeia, a primeira lei abrangente sobre Inteligência Artificial (IA) do mundo. O objetivo principal da lei é garantir que os sistemas de IA utilizados na UE sejam seguros, transparentes, rastreáveis, não discriminatórios e ambientalmente amigáveis. Para atingir esse objetivo, a lei classifica os sistemas de IA em quatro níveis de risco: inaceitável, alto, limitado e mínimo, cada um com diferentes níveis de regulamentação. Sistemas de IA considerados uma ameaça às pessoas são proibidos, enquanto sistemas de alto risco, como aqueles usados em dispositivos médicos ou aplicação da lei, exigem registro em um banco de dados da UE. A lei também exige transparência, como a rotulagem clara de conteúdo gerado por IA, e visa apoiar a inovação, fornecendo ambientes de teste para startups e pequenas e médias empresas. O Parlamento Europeu e o Conselho já aprovaram a lei, que entrará em vigor em diferentes etapas, com a proibição de sistemas de IA de risco inaceitável sendo aplicada primeiro e os sistemas de alto risco tendo o maior prazo para conformidade.

No entanto, enquanto este trabalho aborda a opacidade algorítmica e seus desafios estruturais, é importante também reconhecer as perspectivas otimistas sobre o impacto da IA no mercado de trabalho. Podemos ver um exemplo desse otimismo em textos como“AI Could Actually Help Rebuild The Middle Class” (Autor, 2024). Nele, argumenta-se que a IA, quando utilizada para aumentar as capacidades dos trabalhadores e democratizar o acesso a tarefas complexas, pode fortalecer a classe média. Essa visão —que não deixa de ser interessante e promissora— contrasta com as preocupações predominantes sobre a substituição de trabalhadores e sugere que a IA pode oferecer suporte ao trabalho humano ao invés de substituí-lo, particularmente ao possibilitar que profissionais menos qualificados executem tarefas mais complexas. Para que esse potencial se realize, contudo, é essencial garantir que o desenvolvimento de IA permaneça ancorado em políticas públicas robustas, como as defendidas pelo AI Act da União Europeia, e em uma estrutura ética que assegure que a IA sirva para empoderar e valorizar o trabalho humano, promovendo a justiça social.

Esse debate está alinhado à perspectiva que critica a especulação dos danos reais causados pela IA —tal como argumentam Kapoorsayash Kapoor e Narayananarvind Narayanan (2023). Eles identificam três categorias de danos reais: a dependência excessiva em LLMs para tomada de decisões críticas, que amplifica a desinformação; o impacto sutil da IA no trabalho, onde o poder é transferido dos trabalhadores para as empresas; e a exploração de trabalhadores que desempenham funções como filtragem de conteúdo tóxico, sem garantias de compensação justa ou direitos adequados. Em vez de uma moratória no desenvolvimento da IA, os autores defendem uma regulamentação prática e imediata que proteja os direitos dos trabalhadores e ofereça compensação justa aos criadores cujas produções servem de base para os modelos de IA. Compartilhando dessa perspectiva crítica, o presente trabalho reforça que o caminho para uma evolução tecnológica justa requer não apenas maior transparência, mas também um compromisso com o fortalecimento dos direitos trabalhistas e a criação de um ambiente de trabalho equitativo. Somente por meio de regulamentações claras e ações que promovam uma IA justa e ética será possível garantir que a tecnologia contribua para a dignidade e autonomia dos trabalhadores, em vez de perpetuar desigualdades e concentrar poder nas mãos de poucos.

Referências bibliográficas

Art. 22 GDPR – Automated individual decision-making, including profiling. (s. f.). General Data Protection Regulation (GDPR). Recuperado 7 de noviembre de 2024, de https://gdpr-info.eu/art-22-gdpr/

Autor, D. H. (2024). AI Could Actually Help Rebuild The Middle Class. https://www.noemamag.com/how-ai-could-help-rebuild-the-middle-class

Asquerino Lamparero, M. J. (2022, abril 30). Algoritmos y Discriminación [Site]. Trabajo, Persona, Derecho Y Mercado Nuevos retos del mercado laboral: Pobreza en el trabajo, economía colaborativa y envejecimiento.

Bicchieri, C. (2005). The Grammar of Society: The Nature and Dynamics of Social Norms. Cambridge University Press.

Burrell, J. (2016). How the Machine ‘Thinks’: Understanding Opacity in Machine Learning Algorithms. Big Data and Society, 3(1), 205395171562251.

Cappelen, H. (2018). Fixing Language an Essay on Conceptual Engineering. Oxford University Press.

Creel, K., & Hellman, D. (2022). The Algorithmic Leviathan: Arbitrariness, Fairness, and Opportunity in Algorithmic Decision-Making Systems. Canadian Journal of Philosophy, 52(1), 26-43.

Danaher, J., & Nyholm, S. (2021). Automation, Work and the Achievement Gap. AI and Ethics, 1(3), 227-237.

Danaher, J., & Sætra, H. S. (forthcoming). Mechanisms of Techno-Moral Change: A Taxonomy and Overview. Ethical Theory and Moral Practice, 1-22.

DCWP – Automated Employment Decision Tools (AEDT). (s. d.). Recuperado 7 de noviembre de 2024, de https://www.nyc.gov/site/dca/about/automated-employment-decision-tools.page

Dubal, Veena, On Algorithmic Wage Discrimination (January 19, 2023). UC San Francisco Research Paper No. Forthcoming.

EU AI Act: First regulation on artificial intelligence. (2023, junio 8). Topics | European Parliament. https://www.europarl.europa.eu/topics/en/article/20230601STO93804/eu-ai-act-first-regulation-on-artificial-intelligence

Ferreira, M. (2021). Inscrutable Processes: Algorithms, Agency, and Divisions of Deliberative Labour. Journal of Applied Philosophy, 38(4), 646-661.

Geuss, R. (2021). A Philosopher Looks at Work (1ª). Cambridge University Press.

González, J. R. O., & Teixidó Durán, Ó. F. (2023). Derechos, deberes, justicia y simetría moral desde una filosofía científica. UNIVERSITAS. Revista de Filosofía, Derecho y Política, 42, Article 42. https://doi.org/10.20318/universitas.2023.7850

Hare, S. (2022). Techonolgy is not neutral A short Guide to Technology Ethics. London Published Partnership.

Horgan, A. (2021). Creeping and Ameliorative Accounts of “Work”. Theory & Event, 24(4), 1110-1129.

Infografía—Panorámica de las plataformas digitales en la UE. (2023, marzo 23). [Site]. Consejo Europeo.

Joque, J. (s. f.). Revolutionary Mathematics Artificial Intelligence, Statistics and the Logic of Capitalism (2022.a ed.). Verso.

Kapoorsayash Kapoor, S., & Narayananarvind Narayanan, Y. (2023, marzo 29).A misleading open letter about sci-fi AI dangers ignores the real risks [Site]. Snake Oil.

Loi, M., Ferrario, A., & Viganò, E. (2021). Transparency as Design Publicity: Explaining and Justifying Inscrutable Algorithms. Ethics and Information Technology, 23(3), 253-263.

Löhr, G. (2019). Embodied cognition and abstract concepts: Do concept empiricists leave anything out? Philosophical Psychology, 32(2), 161-185.

Löhr, G. (2023). Do socially disruptive technologies really change our concepts or just our conceptions? Technology in Society, 72.

Marx, K. (2010). El Capital Libro Primero El proceso de Producción del Capital (P. Scaron, Trad.). Siglo XXI editores.

Mittelstadt, B., Allo, P., Taddeo, M., Wachter, S., & Floridi, L. (2016). The ethics of algorithms: Mapping the debate. Big Data and Society, 3(2).

OIT. (2004, agosto 9). ¿Qué es el Trabajo Decente? [Site]. Organización Internacional del Trabajo.

Páez, A., & Ramírez-Bustamante, N. (2022). Análisis jurídico de la discriminación algorítmica en los procesos de selección laboral. En N. Angel & R. Urueña (Eds.), Derecho, poder, y datos: Aproximaciones críticas al derecho y las nuevas tecnologías. Ediciones Uniandes.

Pinheiro-Machado, R. (2024). Why and How Precarious Workers Support Neo-illiberalism. En M. Gabriel, A. Katsman, T. Liess, & W. Milberg (Eds.), Beyond Neoliberalism and Neo-Illiberalism: Economic Policiesand Performance for Sustainable Democracy. The New—Transcript and Columbia University Press.

Romero, G. E. (Director). (2024, julio 9). Inteligencia artificial [Video recording]. https://www.youtube.com/watch?v=-DNqEOUbWFQ

Rueda, J. (2021). Tecnologías socialmente disruptivas (Introducción). Dilemata, 31(13), 5-9.

Soysal, Z. (2021). From Metasemantics to Analyticity. Philosophy and Phenomenological Research, 103(1), 57-76.

Stuart, M., Trappmann, V., Bessa, I., Joyce, S., Neumann, N., & Umney, C. (2023). Labor Unrest and the Future of Work: Global Struggles against Food Delivery Platforms. Labor Studies Journal.

Suarez, T. (2023, junio 7). Le Dialogue Social pour les Travailleurs des Plateformes en France est de la Poudre aux Yeux. Euractiv.fr.

Sullivan, E. (2022). How Values Shape the Machine Learning Opacity Problem. En I. Lawler, K. Khalifa, & E. Shech (Eds.), Scientific Understanding and Representation (pp. 306-322). Routledge.

Toscano, J. (2022). But seriously: What do Algorithms Want? Implying Collective Intentionalities in Algorithmic Relays. A Distributed Cognition Approach. Zagadnienia Filozoficzne W Nauce, 73, 47-76.

Tsamados, A., Aggarwal, N., Cowls, J., Morley, J., Roberts, H., Taddeo, M., & Floridi, L. (2021). The ethics of algorithms: Key problems and solutions. En AI and Society (pp. 1-16).